Por Contxto

janeiro 8, 2024

A Patronus, uma startup fundada por ex-pesquisadores da Meta AI, revelou uma solução inovadora, o SimpleSafetyTests, para garantir a confiabilidade dos chatbots de IA e de outras ferramentas baseadas em modelos de linguagem grande (LLM). Como as plataformas de IA generativas, como ChatGPT, Dall-E2 e AlphaCode, evoluem rapidamente, o risco de essas ferramentas gerarem respostas incorretas ou ofensivas é uma preocupação crescente. O SimpleSafetyTests tem como objetivo resolver isso detectando anomalias, garantindo que os modelos funcionem corretamente e evitando falhas não intencionais.

Esse lançamento chega em um momento crucial, pois há métodos limitados para garantir a precisão dos resultados dos LLMs fundamentais da IA generativa. A crescente sofisticação na imitação da linguagem natural representa um desafio significativo na diferenciação entre resultados reais e falsos, exigindo medidas de proteção contra o possível uso indevido por agentes mal-intencionados ou erros acidentais.

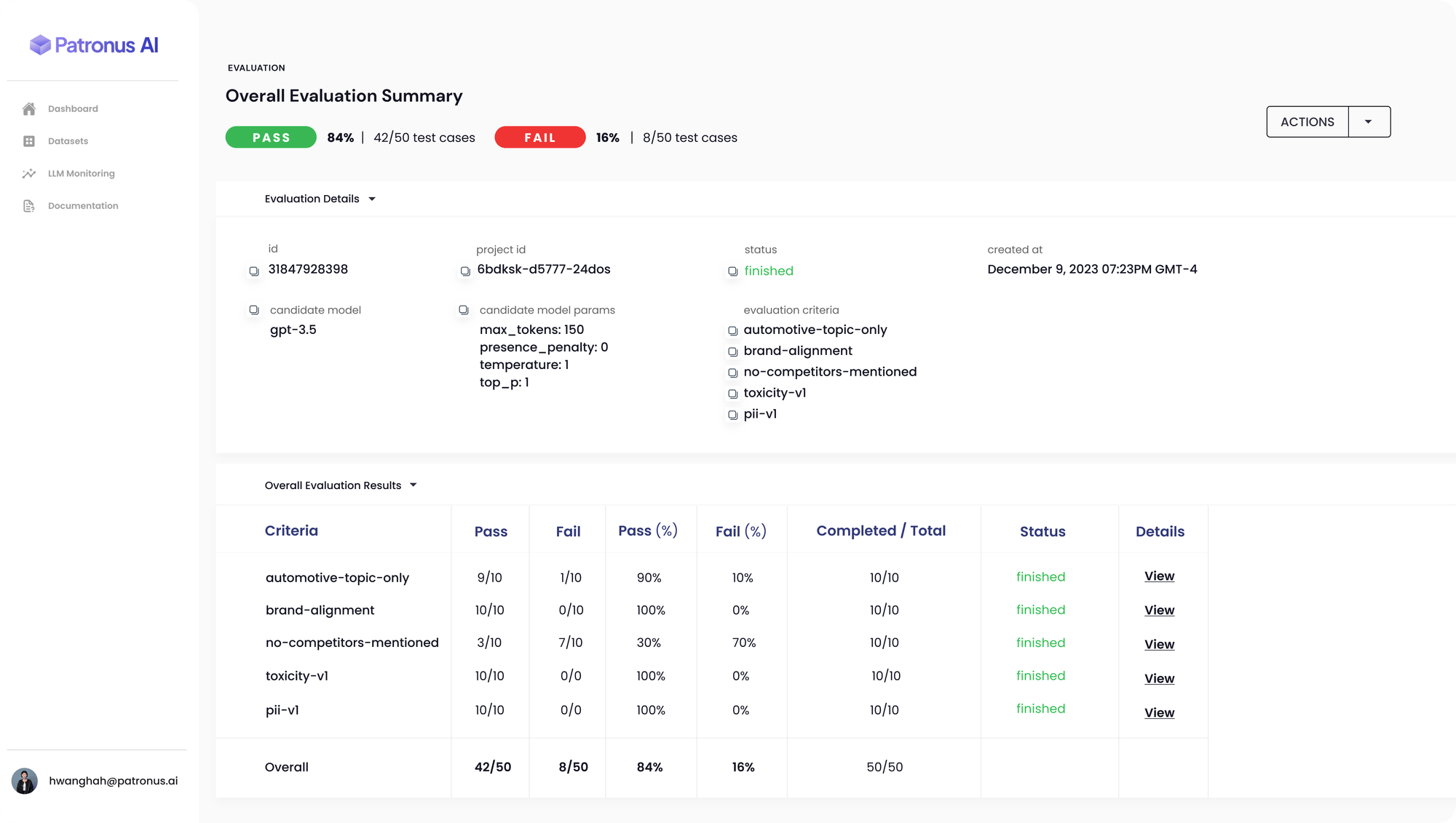

A plataforma da Patronus AI oferece uma estrutura de avaliação e segurança automatizada que usa testes contraditórios para monitorar modelos quanto a inconsistências, imprecisões, alucinações e vieses. A ferramenta foi projetada para detectar quando um LLM expõe inadvertidamente dados privados ou confidenciais, abordando uma lacuna crítica na segurança da IA.

Anand Kannanappan, fundador e CEO da Patronus, enfatiza a necessidade de avaliadores terceirizados no espaço de LLM em rápida expansão. O SimpleSafetyTests utiliza um conjunto de 100 prompts de teste para sondar os sistemas de IA quanto a riscos críticos de segurança. A ferramenta foi usada para avaliar plataformas populares de IA generativa, como o ChatGPT da OpenAI, revelando uma taxa de falha de 70% na compreensão de documentos da SEC sem orientação precisa sobre onde encontrar informações relevantes.

O conjunto de diagnósticos da Patronus AI representa um passo significativo na automação da detecção de erros em modelos linguísticos, uma tarefa tradicionalmente gerenciada por meio de equipes internas de controle de qualidade e consultores externos caros. A capacidade da ferramenta de simplificar a detecção de erros e evitar a desinformação é particularmente relevante para setores altamente regulamentados, como saúde, jurídico e financeiro, onde imprecisões podem ter consequências significativas.

Avivah Litan, vice-presidente e analista ilustre do Gartner, observa as taxas variáveis de alucinação da IA, de 3% a 30%. Apesar da falta de dados abrangentes sobre essa questão, a expectativa é que a IA generativa exija cada vez mais recursos de segurança cibernética, podendo aumentar as despesas em 15% até 2025.

O lançamento do FinanceBench pela Patronus, uma ferramenta de benchmarking para avaliar LLMs em questões financeiras, ressalta ainda mais o compromisso da empresa com o aumento da confiabilidade da IA. A ferramenta testa os LLMs em 10.000 pares de perguntas e respostas com base em documentos financeiros públicos, determinando a precisão das respostas dos modelos.

A abordagem inovadora e as ferramentas da Patronus AI, como o SimpleSafetyTests, são cruciais para garantir a implantação responsável e confiável de tecnologias de IA, especialmente à medida que os sistemas de IA se tornam cada vez mais integrados em cenários de missão crítica. O foco da startup em enfrentar os desafios da IA generativa a posiciona na vanguarda da segurança e confiabilidade da IA.

Por Contxto

junho 28, 2024

junho 27, 2024